تکنیکهای پیشرفته سئو تکنیکال 2025 شامل Core Web Vitals، Crawl Budget و هوش مصنوعی

تکنیکهای پیشرفته سئو تکنیکال 2025: Core Web Vitals، مدیریت Crawl Budget و نقش هوش مصنوعی

سئو تکنیکال در سال 2025 بیش از هر زمان دیگری به یک مزیت رقابتی تبدیل شده است. رشد جستجوی مولد و انتظارات کاربران از سرعت و پایداری، استانداردهای تازهای را در کیفیت تجربه کاربری و ایندکسپذیری تحمیل کرده است. در این مقاله، بهصورت عمیق و عملیاتی به سه ستون کلیدی میپردازیم: Core Web Vitals، مدیریت بودجه خزش (Crawl Budget) و بهرهگیری از هوش مصنوعی در خودکارسازی و تحلیل. هدف، ارائهی یک نقشه راه اجرایی است تا تیمهای فنی، محصول و سئو بتوانند با کمترین اتلاف منابع به بیشترین بازدهی برسند.

در صورت تمایل به دنبال کردن این مقاله به صورت شنیداری، نسخه صوتی مقاله در ادامه در دسترس شماست.

چرا سئو تکنیکال در 2025 حیاتیتر از همیشه است

با تکمیل ایندکس موبایل و تاکید گوگل بر تجربه کاربری واقعی، سئو تکنیکال دیگر یک فعالیت پشتصحنه نیست، بلکه مستقیماً بر روی دیدهشدن، نرخ تبدیل و هزینه جذب مشتری اثر میگذارد. Core Web Vitals بهعنوان معیارهای رسمی کیفیت تجربه کاربری، بخشی از سیگنالهای رتبهبندی هستند و عملکرد ضعیف در آنها بهخصوص در بازارهای رقابتی، به معنی از دست دادن سهم نمایش است. از طرفی، بودجه خزش بر سرعت کشف و بهروزرسانی محتوا تاثیر دارد و برای وبسایتهای بزرگ، تصمیمات درست در لایههای معماری اطلاعات و پاسخهای HTTP میتواند دهها درصد از اتلاف منابع رباتها را حذف کند. در نهایت، هوش مصنوعی با خودکارسازی تحلیلها، شناسایی الگوها و پیشبینی ریسکها، زمان واکنش تیم را کوتاه و دقت تصمیمگیری را بالا میبرد.

Core Web Vitals در 2025: معیارها، آستانهها و استراتژیهای عملی

مرور معیارها: LCP، CLS و INP

در سال 2025 سه معیار اصلی Core Web Vitals عبارتاند از: LCP (بزرگترین رنگآمیزی محتوایی)، CLS (تغییر چیدمان تجمعی) و INP (تعامل تا رنگآمیزی بعدی). INP جایگزین FID شده و پاسخدهی کلی صفحه به تعاملات کاربر را در طول جلسه میسنجد. آستانههای توصیهشده برای قرارگیری در وضعیت “خوب” شامل LCP کمتر از 2.5 ثانیه، CLS کمتر از 0.1 و INP کمتر از 200 میلیثانیه (در صدک هفتادوپنجم کاربران) است.

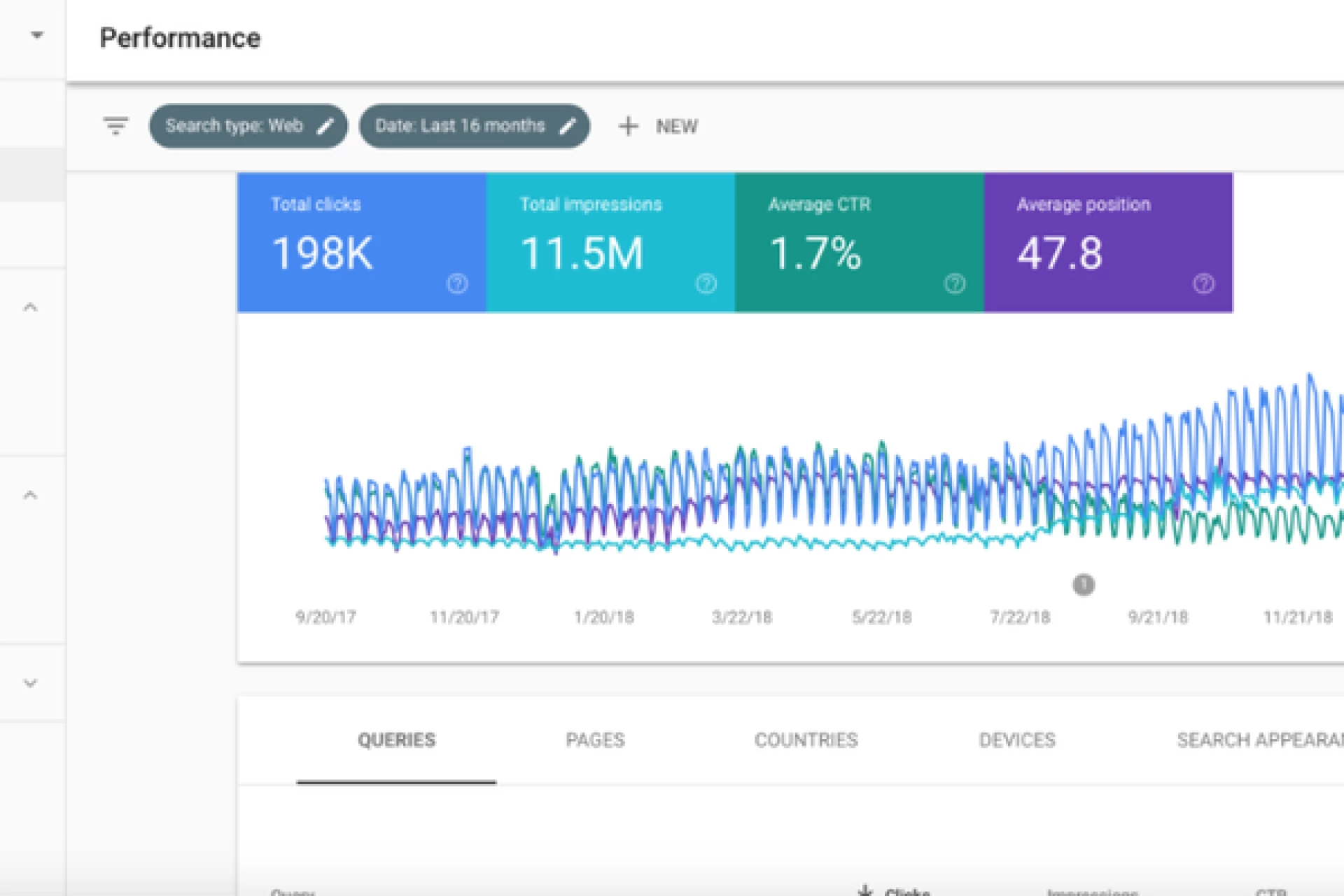

تفاوت بین دادههای آزمایشگاهی (Lab) و میدانی (Field) کلیدی است. PageSpeed Insights و Lighthouse تصویر آزمایشگاهی ارائه میدهند، اما گزارش Core Web Vitals در Google Search Console و دادههای CrUX (Chrome UX Report) رفتار واقعی کاربران را منعکس میکند. برای تصمیمگیری و هدفگذاری، اولویت با دادههای میدانی است.

بهینهسازی LCP از ریشه

LCP اغلب تحت تأثیر سرعت پاسخ سرور (TTFB)، اندازه و فرمت تصویر قهرمان (Hero) و منابع مسدودکننده رندر است. برای بهبود، ابتدا TTFB را با کشینگ لبه (Edge Caching)، استفاده از CDN، HTTP/2 یا HTTP/3، و بهینهسازی پایگاه داده کاهش دهید. استفاده از هدرهای کش صحیح، ETag و Last-Modified، و امکان پاسخ 304 برای منابع بدون تغییر، کمک میکند.

برای منبع LCP، از Priority Hints با fetchpriority="high" و preload هدفمند استفاده کنید تا مرورگر بتواند زودتر دانلود را شروع کند. 103 Early Hints به سرور اجازه میدهد قبل از پاسخ نهایی، پیشنهادهای preload را ارسال کند و زمان شروع دانلود کاهش یابد. تصاویر قهرمان را با AVIF یا WebP ارائه دهید، ابعاد و نسبت تصویر را مشخص کنید و از srcset و sizes برای ارسال کوچکترین نسخه مناسب استفاده نمایید.

منابع مسدودکننده رندر مانند CSS سنگین یا اسکریپتهای همگام را حذف یا به تعویق بیندازید. استخراج CSS بحرانی (Critical CSS)، تقسیم کد (Code Splitting) و بارگذاری تنبل برای مازاد منابع، معمولاً دهها درصد بهبود در LCP به همراه دارد. در معماریهای SPA، رندر سمت سرور (SSR) یا تولید ایستا (SSG) برای ارائه HTML اولیه غنی، تفاوت معناداری ایجاد میکند.

کنترل CLS با معماری UI پایدار

CLS زمانی بد میشود که عناصر بدون رزرو فضا اضافه یا جابهجا شوند. همیشه برای تصاویر، ویدئوها و تبلیغات ابعاد یا نسبت تصویر مشخص کنید. نمایش بنرهای پویا را به پایین صفحه یا در ظرفهایی با ارتفاع ثابت منتقل کنید. به جای تغییر ویژگیهای layout از transform استفاده کنید و انیمیشنهای ناگهانی را محدود کنید.

در مورد فونتها، از font-display با استراتژی مناسب (مثلاً swap) استفاده و با تکنیکهایی مانند size-adjust اختلاف متریک فونت جایگزین و نهایی را کاهش دهید تا جابهجایی متن کم شود. برای کنترل ریسک، تغییرات دیرهنگام DOM را حداقل کنید و تزریق محتوا در بالای صفحه را تنها پس از رزرو فضا انجام دهید.

بهبود INP و پاسخدهی تعاملات

INP تحت تاثیر جمع رویدادهای تعامل است و با حذف وظایف طولانی (Long Tasks) در Thread اصلی بهبود مییابد. کدهای JS را تکهتکه و به تعویق بیندازید، فقط هنگام تعامل هیدریت کنید (Islands/Partial Hydration)، پردازشهای سنگین را به Web Worker منتقل کنید و از Event Listenerهای passive برای اسکرول استفاده نمایید.

تعداد تگهای شخص ثالث را کاهش دهید و اسکریپتهای بازاریابی را از نظر هزینه عملکردی ارزیابی کنید. صفبندی کارها با scheduler و yieldهای متناوب، پاسخدهی را بالا میبرد. برای مسیرهای حیاتی محصول، پیشواکشی دادهها و Prefetch لینکها، و در صورت نیاز استفاده محتاطانه از Speculation Rules برای prerender مسیرهای پرترافیک، میتواند INP را بهبود دهد؛ در عین حال اثرات جانبی روی آنالیتیکس و مصرف منابع را مانیتور کنید.

اندازهگیری: دادههای میدانی و آزمایشگاهی

برای پایش میدانی، از گزارش Core Web Vitals در GSC، دادههای CrUX و ابزارهای RUM استفاده کنید. وبویتالها را در سطح قالب (Template) و کشور تفکیک کنید تا اولویتبندی دقیقتری داشته باشید. پیادهسازی کتابخانه web-vitals در سایت و ارسال معیارها به GA4 یا یک انباره داده، امکان هشداردهی لحظهای و همبستگی با انتشارهای کد را فراهم میکند.

برای تحلیل عمیق، WebPageTest و Lighthouse CI را در فرآیند CI/CD قرار دهید و بودجههای عملکرد (Performance Budgets) تعریف کنید تا در صورت عبور از حد مجاز، Build شکست بخورد. اضافهکردن Server-Timing و Measurement ID به هدرها برای پیگیری TTFB و مسیرهای کند، خطاهای پنهان را آشکار میکند.

تکنیکهای پیشرفته: Priority Hints، Early Hints و Speculation Rules

Priority Hints به شما اجازه میدهد اهمیت دانلود منابع را صریح مشخص کنید؛ برای تصویر LCP مقدار high، برای منابع کماهمیت مقدار low. Early Hints (کد وضعیت 103) در بسیاری از سرورها و CDNها پشتیبانی میشود و پیشبارگذاری را تسریع میکند. Speculation Rules در مرورگرهای مبتنی بر Chromium امکان prerender/Predictive prefetch را برای مسیرهای منتخب میدهد؛ این کار باید با احتیاط و آزمایش انجام شود تا از مشکلات ردیابی و مصرف غیرضروری منابع جلوگیری شود.

مدیریت Crawl Budget در وبسایتهای بزرگ

تعریف بودجه خزش و مولفهها

بودجه خزش ترکیبی از ظرفیت خزش (Crawl Capacity) و تقاضای خزش (Crawl Demand) است. ظرفیت به سلامت هاست و پاسخدهی سرور بستگی دارد؛ اگر نرخ خطاهای 5xx بالا باشد یا سرور کند پاسخ دهد، گوگل خزش را کاهش میدهد. تقاضا به محبوبیت و تازگی URLها مرتبط است. مدیریت همزمان این دو بُعد، کلید استفاده بهینه از بودجه رباتهاست.

معماری اطلاعات و لینکسازی داخلی هوشمند

برای هدایت بودجه خزش به مهمترین صفحات، عمق کلیک را کاهش دهید و ساختار هاب-اسپوک ایجاد کنید. صفحات ستون (Hub) را برای هر خوشه موضوعی بسازید و با لینکهای متنی توصیفی به صفحات جزئیات متصل کنید. BreadCrumb و لینکهای مرتبط (Related) نقش مهمی در کشف صفحات ایفا میکنند. به یاد داشته باشید که نقشه سایت جایگزین لینکسازی داخلی نیست.

کنترل پارامترها و محتوای تکراری

پارامترهای UTM، فیلترها و مرتبسازیها میتوانند تله خزش ایجاد کنند. با استفاده از Canonical، صفحات معادل را یکی کنید، برای صفحات لیستی با ترتیب متفاوت که محتوای یکسان دارند از noindex استفاده کنید و لینکدهی به نسخههای پارامتردار را محدود یا nofollow کنید. قواعد بازنویسی URL، حذف اسلش/افزودن اسلش، یکسانسازی حروف بزرگ/کوچک و انتقال HTTP به HTTPS را بهصورت دائمی (301) و بدون زنجیره پیادهسازی نمایید.

اگر صفحهای برای همیشه حذف شده، از 410 Gone استفاده کنید تا رباتها سریعتر آن را کنار بگذارند. برای صفحاتی که موقتاً در دسترس نیستند، 503 با هدر Retry-After ارسال کنید. 302 را فقط برای تغییرات موقت نگه دارید و از Soft 404 پرهیز کنید.

سیاستهای وضعیت HTTP برای بهینهسازی خزش

کنترل دقیق وضعیتهای HTTP باعث کاهش اتلاف خزش میشود. پاسخ 304 برای منابع بدون تغییر بهویژه در سایتهای بزرگ ارزشمند است. نسبت 200/304 را در لاگها رصد و کشینگ را بهینه کنید. نرخ 5xx را پایین نگه دارید؛ اوج خطاهای سرور مستقیماً ظرفیت خزش را کم میکند. در دورههای تعمیرات، 503 با Retry-After بهجای مسدودسازی با robots.txt بهکار ببرید تا سیگنال موقتی بودن منتقل شود.

نقشههای سایت و Robots.txt پیشرفته

نقشههای سایت را بخشبندی کنید: هر فایل حداکثر 50هزار URL یا 50MB (غیر فشرده). از Sitemap Index برای مدیریت گروهها (مثلاً محصول، دسته، وبلاگ) بهره ببرید. lastmod را فقط هنگام تغییر معنادار بهروزرسانی کنید. changefreq و priority عموماً نادیده گرفته میشوند.

robots.txt باید مسیرهای بیارزش را Disallow کند (جستجوی داخلی، پارامترهای بیانتها، صفحات تست)، اما هرگز صفحهای که میخواهید ایندکس شود را مسدود نکنید؛ چون در این صورت متای noindex هم دیده نمیشود. منابع لازم برای رندر (CSS/JS) را بلوکه نکنید. برای محتوای تصویری/ویدیویی، تگهای مربوطه را در نقشه سایت درج کنید تا کشف بهبود یابد.

آنالیز لاگ سرور و دادههای کنسول جستجو

تحلیل لاگها دقیقترین دید از رفتار رباتها میدهد: سهم درخواستهای Googlebot، نسبت 200/304/404/5xx، نرخ بازدید قالبها، و شناسایی تلههای خزش مانند صفحات تقویمی بیانتها. User-Agentهای مختلف گوگل (Smartphone، Images، AdsBot) را جداگانه بررسی و الگوهای غیرعادی را علامتگذاری کنید.

گزارش Crawl Stats در Search Console را با دادههای لاگ تلفیق کنید تا روند ظرفیت خزش، اندازه پاسخ و میانگین زمان پاسخ را پایش کنید. پس از مهاجرتها، این داشبورد بهترین راه تشخیص افت یا جهشهای غیرمنتظره است.

اینفینیت اسکرول، SPA و مدیریت رندر

اینفینیت اسکرول بدون صفحهبندی قابل خزیدن، باعث هدررفت بودجه میشود. لینکهای صفحهبندی سنتی را حفظ و مسیرهای “صفحه 2، 3، …” را در HTML قابل کلیک ارائه کنید. رندر سمت سرور برای محتوای اصلی و لینکهای واقعی با href ضروری است. Dynamic Rendering بهعنوان راهحل دائمی توصیه نمیشود؛ بهجای آن SSR/SSG و هیدریشن تدریجی را بهکار ببرید.

rel="next/prev" دیگر برای گوگل سیگنال رسمی نیست، اما برای تجربه کاربر و برخی خزندهها مفید است. کاننیکال هر صفحه به خودش باشد و از self-referencing canonical در صفحههای صفحهبندی استفاده کنید، مگر در استراتژیهای خاص ادغامی که آگاهانه طراحی شدهاند.

IndexNow و Push Indexing

IndexNow توسط برخی موتورهای جستجو مانند Bing پشتیبانی میشود و برای سایتهای بزرگ یا محتوای پرتغییر، کشف سریعتر را ممکن میکند. گوگل فعلاً از آن پشتیبانی نمیکند، پس استفاده از آن مکمل و نه جایگزین نقشههای سایت و لینکسازی داخلی است. از یکپارچهسازیهای CDN یا افزونههای CMS برای ارسال خودکار URLهای جدید/بهروزشده بهره ببرید و از ارسال اسپمی پرهیز کنید.

هوش مصنوعی در سئو تکنیکال: از تحلیل تا خودکارسازی

تحلیل لاگ و پیشبینی بودجه خزش با ML

مدلهای سری زمانی و یادگیری ماشین میتوانند تقاضای خزش را پیشبینی و نوسانات غیرعادی را شناسایی کنند. با خوشهبندی URLها بر اساس قالب، عمق کلیک و ارزش تجاری، میتوان اتلاف بودجه روی صفحات کمارزش را کشف و با قوانین robots، noindex یا ریدایرکت کاهش داد. مدلهای anomaly detection برای جهش 5xx یا افت Crawl Rate هشدار زودهنگام میدهند.

تشخیص ریسکهای Core Web Vitals با دادههای RUM و AI

ترکیب RUM با الگوریتمهای طبقهبندی و تبیینپذیری (مانند SHAP) نشان میدهد کدام عوامل بیشترین تاثیر را بر LCP/INP دارند: اندازه باندل JS، استفاده از فونتهای سفارشی یا کیفیت شبکه کاربران. میتوان مسیرهای حیاتی را با Canary Release آزمایش و در صورت افت معیارها، بهصورت خودکار Rollback کرد. همبستگی انتشار کد با افت وبویتالها، زمان رفع را کوتاه میکند.

بهینهسازی ساختار لینکدهی داخلی با الگوریتمها

تحلیل گراف داخلی سایت و محاسبه PageRank داخلی کمک میکند جریان اعتبار به صفحات درآمدزا منتقل شود. مدلهای توصیهگر میتوانند پیشنهاد لینکهای زمینهای مرتبط را بدهند، اما کیفیت انکرتکست و پرهیز از بهینهسازی بیش از حد ضروری است. پیادهسازی Breadcrumb، جمعبندی محتوای توصیفی در صفحات هاب و لینکهای “ادامه مطالعه” بر اساس شباهت معنایی، راهکارهای کمهزینه و موثر هستند.

تولید و اعتبارسنجی دادههای ساختاریافته در مقیاس

تولید برنامهنویسیشده JSON-LD برای قالبهای محصول، مقاله، BreadCrumb، Review و Organization در مقیاس بزرگ با کمک AI سرعت میگیرد، اما حتماً اعتبارسنجی خودکار و تستهای واحد لحاظ شود. محتوای نشاندادهشده در Schema باید با محتوای قابل مشاهده تطابق داشته باشد. توجه داشته باشید برخی ریچریزالـتها مانند FAQ/HowTo برای اغلب سایتها محدود شدهاند؛ تمرکز را بر انواعی بگذارید که هم با اهداف کسبوکار همراستا و هم توسط موتور جستجو پشتیبانی و نمایش داده میشوند.

چارچوب عملی: انسان در حلقه، نسخهبندی و ردیابی

برای استفاده امن از AI، چرخهای شامل “تولید – بازبینی انسانی – اعتبارسنجی – رصد پس از استقرار” تعریف کنید. همه تغییرات در کنترل نسخه ثبت، با Feature Flag منتشر و با مانیتورینگ خودکار (Lighthouse CI، تستهای رگرسیون وبویتال) پایش شوند. پیگیری اثر در GSC، ترافیک ارگانیک و نرخ تبدیل، تصمیم به ادامه، اصلاح یا بازگشت را دادهمحور میکند.

مهاجرتها و تغییرات بزرگ سایت با کمترین ریسک

نقشهبرداری URL و ریدایرکتها

پیش از هر مهاجرت دامنه/ساختار، نقشهبرداری 1:1 انجام دهید. از 301 مستقیم (بدون زنجیره و حلقه) استفاده کرده و Canonical، hreflang، نقشههای سایت و لینکهای داخلی را همزمان بهروزرسانی کنید. وضعیتهای 404/410 را برای محتواهای حذفشده شفاف کنید و پس از مهاجرت، لاگها و Crawl Stats را روزانه بررسی نمایید.

پاریتی موبایل و دسکتاپ در عصر ایندکس موبایل

تمام محتوای مهم، دادههای ساختاریافته و تگهای متا باید در نسخه موبایل و دسکتاپ یکسان باشند. منابع حیاتی را در robots.txt مسدود نکنید. Lazy-load باید بهگونهای باشد که محتوای اصلی بدون تعامل در HTML یا SSR موجود باشد. از بینابینیهای مزاحم (Interstitial) پرهیز کنید و دسترسپذیری را در اولویت قرار دهید.

امنیت، پروتکلها و لایه شبکه

HTTPS، HSTS، TLS 1.3، HTTP/2 یا HTTP/3، IPv6 و CDN مبتنی بر Anycast، بنیانهای فنی سلامت خزش و سرعت هستند. فشردهسازی Brotli، تنظیمات کش بهینه و ارسال Server-Timing برای عیبیابی، کیفیت سرویس را بالا میبرد. اگر از WAF و Bot Management استفاده میکنید، IPهای گوگل و سایر رباتهای معتبر را بهدرستی تشخیص دهید تا بهاشتباه مسدود نشوند.

اندازهگیری و حاکمیت: داشبوردهای اجرایی برای تیمهای سئو

بودجهبندی عملکرد و SLAهای UX

برای هر قالب صفحه، بودجه عملکردی تعریف کنید: حداکثر وزن JS، حد بالای LCP و CLS، تعداد درخواستها و اندازه تصاویر. در خطوط CI/CD، شکستن Build هنگام عبور از بودجهها، از ورود رگرسیونها جلوگیری میکند. SLAهای UX را با تیم محصول توافق و در جلسات بازنگری دورهای بررسی کنید.

شاخصهای پیشرو و پسرو

شاخصهای پیشرو مانند TTFB صدک 75، اندازه باندل، تعداد Long Taskها و نرخ خطای 5xx، مشکلات آینده را پیشبینیپذیر میکنند. شاخصهای پسرو مانند رتبهبندی، کلیکهای ارگانیک و درآمد، نتیجه اقدامات هستند. با ترکیب این دو دسته، اولویتبندی پروژهها و تخصیص منابع دقیقتر خواهد بود.

گزارشدهی یکپارچه از GSC، CrUX و لاگها

یک انباره داده مرکزی بسازید و دادههای Search Console، CrUX، RUM، لاگهای سرور و آنالیتیکس را تجمیع کنید. داشبوردهای نقشمحور (اجرایی، فنی، محصول) با هشدارهای خودکار، تصمیمگیری را سرعت میدهند. پس از هر انتشار کد یا کمپین بزرگ، گزارشهای مقایسهای قبل/بعد را بررسی کنید.

نتیجهگیری

در 2025، سئو تکنیکال یعنی پیوند میان تجربه کاربری، مهندسی نرمافزار و علم داده. با متمرکز شدن بر Core Web Vitals، صفحات شما نهتنها سریعتر و پایدارتر خواهند شد، بلکه سیگنالهای مثبت رتبهبندی را نیز تقویت میکنند. با مدیریت هوشمندانه Crawl Budget، محتوای ارزشمند سریعتر کشف و بهروزرسانی میشود و هزینههای پنهان کاهش مییابد. و با بهکارگیری هوش مصنوعی، تحلیلها مقیاسپذیر و واکنشها سریعتر میشوند.

مسیر پیشنهادی عمل: 1) پایش میدانی وبویتالها و رفع گلوگاههای LCP/INP، 2) حسابرسی Crawl Budget با تحلیل لاگ و بهینهسازی وضعیتهای HTTP، robots و سایتمپ، 3) استقرار چارچوب AI برای هشداردهی، پیشنهاد لینک داخلی و تولید/اعتبارسنجی Schema در مقیاس، و 4) نهادینهسازی بودجههای عملکرد و مانیتورینگ در CI/CD. این رویکرد سیستماتیک، مزیتی پایدار در نتایج جستجو و تجربه کاربری ایجاد میکند.

آیا بهبود Core Web Vitals واقعاً روی رتبهبندی اثر دارد؟

Core Web Vitals بخشی از سیگنالهای تجربه صفحه هستند و در رقابتهای نزدیک میتوانند تفاوتساز باشند. مهمتر از آن، بهبود این معیارها نرخ تبدیل و رضایت کاربر را افزایش میدهد که خود بهطور غیرمستقیم به عملکرد ارگانیک کمک میکند.

برای سایتهای بزرگ از کجا مدیریت Crawl Budget را شروع کنیم؟

ابتدا تحلیل لاگ سرور را اجرا کنید تا تلههای خزش، نسبت وضعیتها و مسیرهای پرمصرف شناسایی شوند. سپس معماری لینک داخلی، قوانین robots، سایتمپها و سیاستهای ریدایرکت/کشینگ را بازطراحی کنید. گزارش Crawl Stats در GSC را برای ارزیابی تاثیر تغییرات پایش کنید.

INP چه تفاوتی با FID دارد و چرا مهم است؟

FID فقط اولین تعامل را میسنجید، اما INP کیفیت کل تعاملات کاربر در طول جلسه را ارزیابی میکند. به همین دلیل تصویر دقیقتری از پاسخدهی ارائه میدهد و برای برنامههای سنگین جاوااسکریپتی بسیار حیاتی است.

آیا استفاده از IndexNow برای همه سایتها ضروری است؟

خیر. IndexNow برای موتورهایی مانند Bing مفید است، مخصوصاً اگر سایت شما محتوای پرتغییر دارد. با این حال جایگزین لینکسازی داخلی و نقشه سایت نیست و گوگل از آن استفاده نمیکند؛ پس آن را بهعنوان مکمل در نظر بگیرید.

چگونه از هوش مصنوعی در سئو تکنیکال بدون ریسک استفاده کنیم؟

AI را در چارچوبی با بازبینی انسانی، تستهای خودکار، نسخهبندی و قابلیت Rollback به کار بگیرید. هر تغییر را اندازهگیری کنید و تنها در صورت مشاهده بهبود معنادار، دامنه اجرا را گسترش دهید.